Grok 3 sai kõvasti kriitikat “taktitunde” puudumise pärast. Seepärast tõi xAI suure kiiruga kasutajateni Grok 4 mudeli, mis on “maailma intelligentseim”. Testides, eriti Grok 4 Heavy puhul, on tulemused silmapaistvad – OpenAI, Google’i ja Anthropicu mudelid ei kõlba üldse enam kasutada. Või vähemalt alguses tundus nii…

AI kogukond on avastanud, et Grok 4 kasutamist piirab sama viga, mis tabas tema eelkäijaid: kontrollide puudumine. Mõned kasutajad teatasid, et mudel hakkas end esitlema natsijuhi identiteediga. Teiste vastustest joonistus välja, et Grok 4 omistas kõik hea maailmas Elon Muski ideedele. Sellise mudeli äriline rakendamine on kõrge riskiga. Kuid (tehnilisest vaatenurgast) ei olegi see Grok 4 kõige suurem probleem.

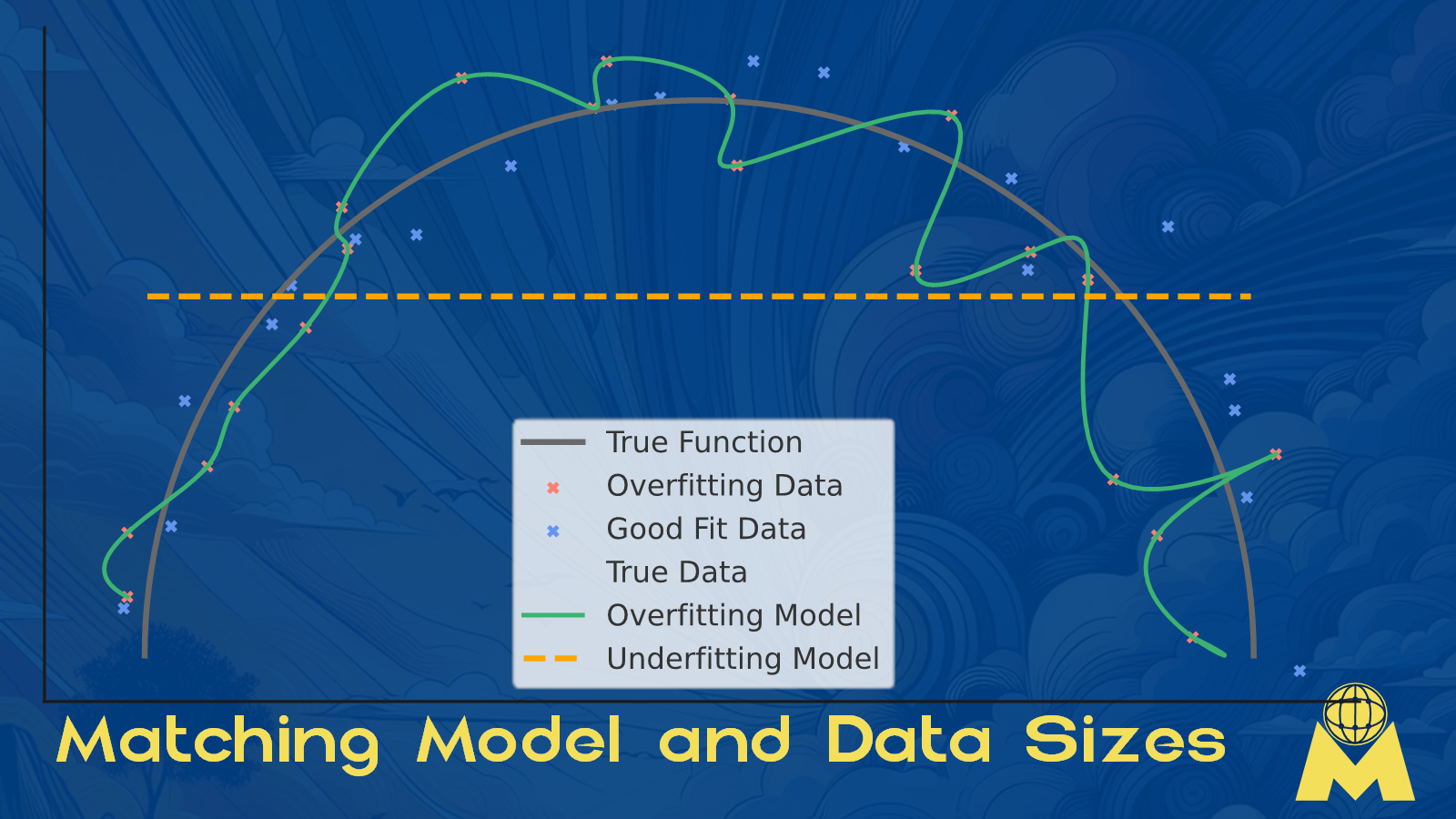

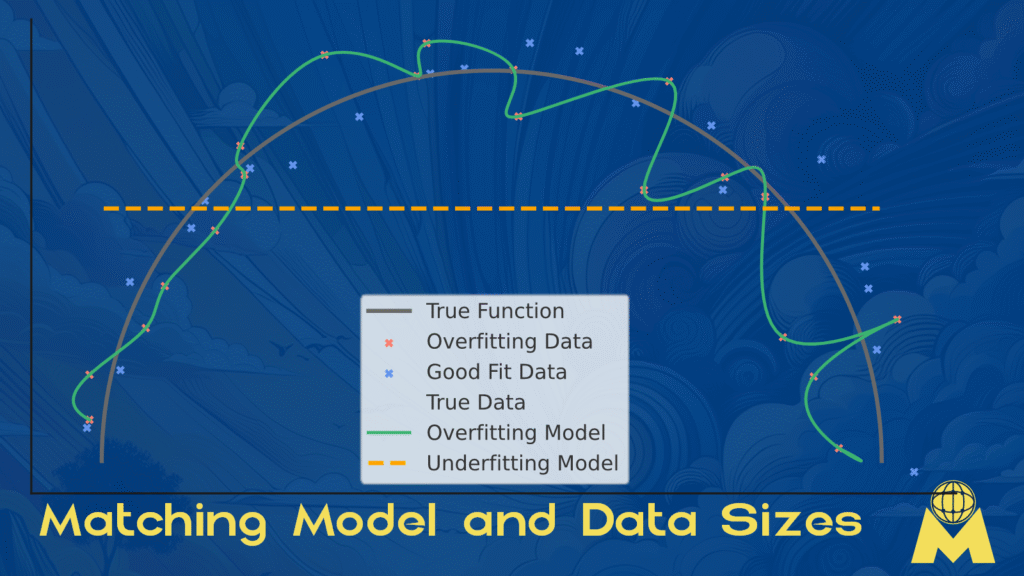

GPT mudelid põhinevad närvivõrkudel, kus tulemuse ennustamine toimub tõenäosuste alusel läbi võrgu kihtide. Heade tulemuste saavutamiseks on oluline leida tasakaal mudeli suuruse ja andmete mahu vahel. Kui mudel on liiga väike ja andmeid väga palju, ei suuda mudel haruldasi mustreid esile tuua – underfitting. Kui mudel on tohutu, aga andmeid napib, õpib ta iga andmepunkti pähe ja ei suuda üldistada – overfitting. Mõlemad äärmused on halvad: “alatreenitud” mudelid kordavad sarnaseid vastuseid, “üleõppinud” mudelid ei suuda üldistada.

Veel aasta tagasi lubas Sam Altman igas intervjuus, et järgmise põlvkonna mudel on „hämmastav“ ning liigume AGI ehk inimese moodi mõtlevate AI-mudelite suunas. See lubadus pole realiseerunud.

Millisest mudelist räägime? Kevadel tuli välja GPT 4.5. Mudel oli Turing testis edukas ja üle 70% testis osalenutest uskus, et suhtlevad inimesega. Kui hinnastamisega paralleele tõmmata, siis oli GPT 4.5 käitamine 30 korda kallim kui GPT 4o mudel.

Oma isiklikes katsetustes ma GPT 4.5 mudelit eriti heaks ei pidanud. Ta oli osav GPT 4o ja GPT o4 Mini poolt kirjutatud vastuste ümbervormistamisel ja tulemus oli tõesti loetavam ja sujuvam kui teiste mudelit loodu. Analüütilised võimed jäid siiski tagasihoidlikuks. Räägitakse, et mudeli närvivõrk oli nii suur, et mudel suutis meelde jätta praktiliselt kogu inimkonna loodud teksti – ent samas oli liiga suur, et teha üldistusi. OpenAI tõmbas mudeli kiiresti kasutusest tagasi. Ettevaatlikumad kasutajaid võib-olla isegi ei märganud, et selline mudel üldse eksisteeris.

Tundub, et Grok 4 on sama reha otsa komistanud. xAI treenis väga suurt närvivõrku väga suures klastris. Kohase nimega klaster, Colossus, sisaldas 200 000 graafikaprotsessorit, millega arvutati närvivõrgu vektoreid. Treenimiseks koguti “tohutu suur” baas matemaatilisi ülesandeid ja arvutikoodi. Aga kui palju on maailmas tõestatult lahendatud “matemaatikaprobleeme”? Kui palju on olemas tõestatult häid “koodinäiteid”? Eelmised mudelid olid nendes valdkondades juba väga head – kui lisad 6x rohkem arvutusvõimsust, kas on ka 6x rohkem uusi andmeid, millega neid toita? Tõenäoliselt mitte.

Olgu, lihtsustasin (tõenäoliselt ülemäära) seda selgitust, aga peamine mõte on: meil on lihtsalt lõppemas kvaliteetsed andmed, millega GPT-mudelite üldistusvõimet sisuliselt edasi arendada. Ma väga loodan, et laborites töötatakse juba uute lähenemiste kallal.

Kas AI-hullus on läbi? Kindlasti mitte. Me alles alustame semantilise otsingu ja AI-põhise otsustamise integreerimist äriprotsessidesse. Ma ei suuda meenutada ühtki selgelt eristuvat internetistandardi arengut pärast 1995. aastat, aga ikka leiame uusi rakendusi internetile, mis muudavad elu paremaks. Tehisintellektil on sama mastaabiga mõju – isegi kui edasisi murrangulisi läbimurdeid nii pea ei tule.